里程碑!DeepSeek-R1 论文荣登《自然》封面,成首个经同行评审大语言模型,梁文锋为关键作者

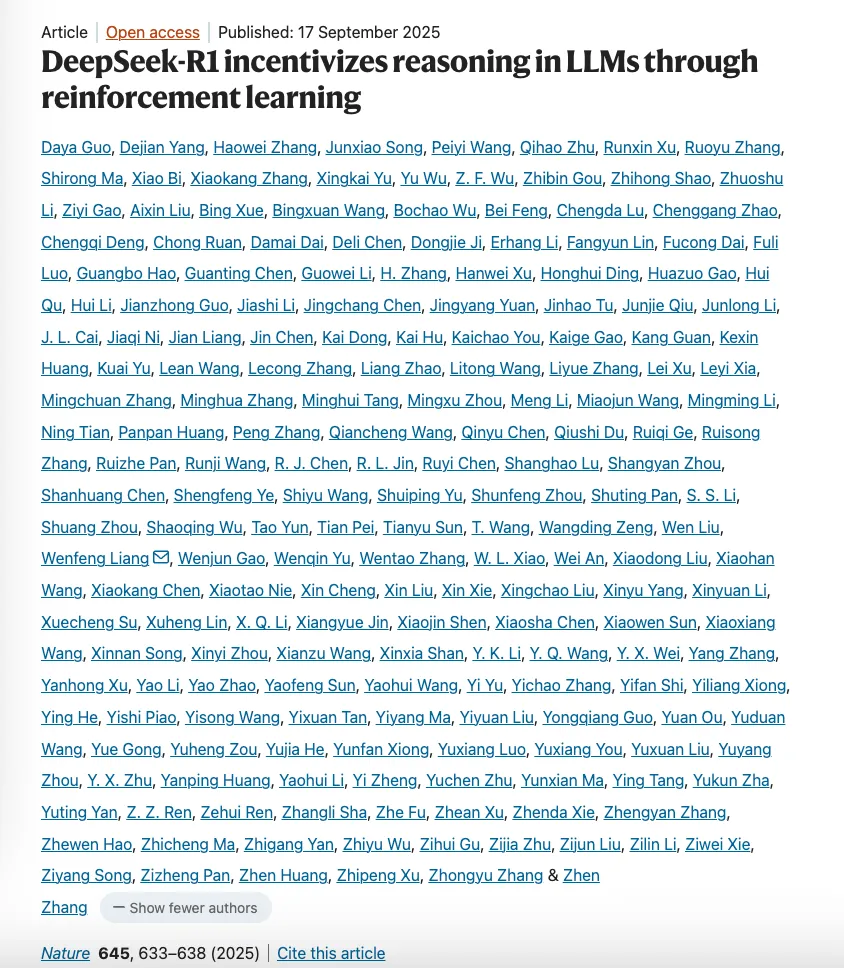

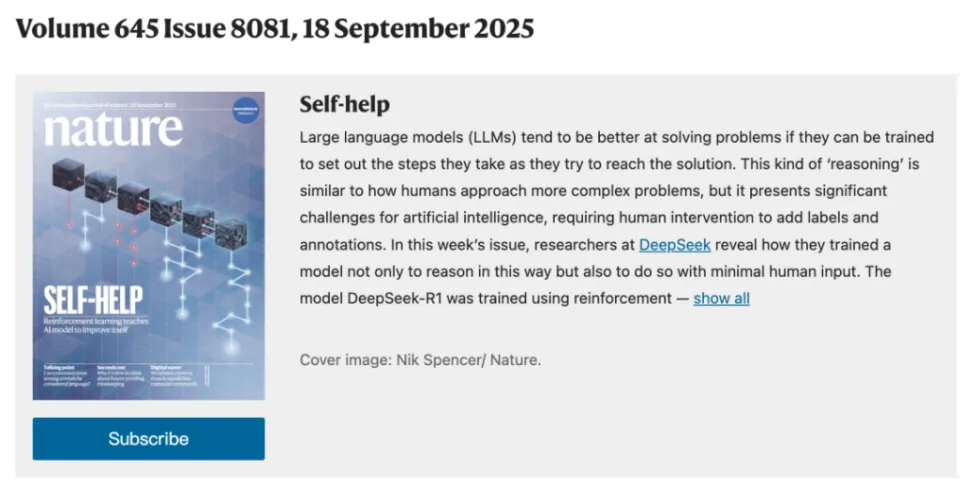

9 月 17 日,国际权威期刊《自然》(Nature)第 645 期封面揭晓,由 DeepSeek 团队共同完成、梁文锋担任通讯作者的 DeepSeek-R1 推理模型研究论文赫然在列,这一事件在 AI 领域投下重磅炸弹。因为 DeepSeek-R1 自此成为全球首个经过严格同行评审的主流大语言模型,填补了行业空白,为大模型的学术验证树立全新标杆。

今年 1 月,DeepSeek 团队在预印本平台 arxiv 公布 DeepSeek-R1 相关论文时,便凭借独特的 “仅靠强化学习激发大模型推理能力” 研究成果,引发业内广泛关注,被赞为 “国产 AI 黑马”。自 1 月在 Hugging Face 发布以来,DeepSeek-R1 更是实力出圈,荣膺该平台复杂问题解决类模型下载量冠军,截至目前下载量超 1090 万次,人气居高不下。

此次登上《自然》封面的论文,相较 1 月未经同行评审的初版,进行了大幅优化与完善。一方面,团队根据评审意见,减少对模型的拟人化描述,让表述更贴合科学严谨性;另一方面,新增大量模型训练技术细节,涵盖数据类型、安全性考量等关键信息,还在长达 64 页的同行评审文件中,正面回应模型发布之初备受争议的蒸馏质疑。DeepSeek 介绍,DeepSeek-V3 Base(DeepSeek-R1 的基座模型)数据均来自互联网,虽或含 GPT-4 生成结果,但绝非刻意为之,更无专门蒸馏环节,同时在补充材料中详细阐释减轻数据污染的训练流程,力证模型 “清白”。

《自然》杂志对 DeepSeek-R1 此番突破给予高度评价,在社论中直言:当下几乎所有主流大模型都未经历独立同行评审,这一严重空白 “终于被 DeepSeek 打破”。在 AI 行业,未经证实的说法与炒作屡见不鲜,而 DeepSeek 此举无疑是迈向透明度与可重复性的重要一步。并且,在公开安全基准测试和内部安全研究里,DeepSeek-R1 表现卓越,多数基准超越 Claude-3.7-Sonnet、GPT-4o 等前沿模型,其强化学习组件独立训练,不依赖其他高能力模型输出或指导,安全性同样领先。

从投稿到发表,DeepSeek-R1 论文历经漫长审核周期。今年 2 月 14 日提交至《自然》,直至 7 月 17 日才被接收,9 月 17 日正式发布。期间,8 位外部专家参与同行评审,从原创性、方法论到稳健性,对论文进行全方位严苛评估。最终发布版本中,审稿报告与作者回复一并披露,文件长达 64 页,近论文篇幅 3 倍。审稿人提出上百条意见,大到数据污染、模型安全性关切,小到单词单复数细节,促使论文不断打磨完善。

作为 2023 年由幻方量化孵化、成立于杭州的人工智能公司,DeepSeek 在梁文锋领衔下,汇聚顶尖高校与国际机构技术专家。此次 DeepSeek-R1 论文登上《自然》封面,不仅是对团队技术实力的高度认可,更标志着中国在大模型基础研究领域取得重大突破,为全球 AI 行业科研透明度提供宝贵借鉴,激励更多 AI 公司投身模型评审,推动行业健康、有序发展。

免责声明:喧喧博客 转载或发布此文目的在于传递更多信息,不代表本网的观点和立场。可能包含AI辅助内容,文章内容仅供参考,不构成投资建议。投资者据此操作,风险自担。

550

550

联系我们

联系我们

社群交流

社群交流